Sitemap-Fehler in der Google Search Console erklärt

Du öffnest die Google Search Console, klickst auf “Sitemaps” und erstarrst. Rote Fehlermeldungen. “Konnte nicht abgerufen werden.” “1 Fehler.” Dein Puls steigt. Was habe ich falsch gemacht? Ist mein SEO jetzt kaputt? Verliere ich Rankings?

Ich kenne dieses Gefühl. Nicht aus der Theorie, sondern aus der Praxis – von meiner eigenen Website.

Als ich kürzlich meine Sitemap-Struktur optimiert habe (von einer chaotischen einzelnen Datei zu einer sauberen 1+3-Architektur), passierte genau das: Google zeigte mir Fehler bei alten Sitemap-URLs an. Obwohl technisch alles korrekt war. Obwohl ich professionelle 301-Redirects eingerichtet hatte.

In diesem Artikel zeige ich dir an einem Live-Beispiel meiner eigenen Website, was hinter den häufigsten Sitemap-Fehlern steckt, wann sie harmlos sind und wann du wirklich handeln musst. Keine Theorie – nur Praxis, Troubleshooting und ehrliche Einschätzungen aus 5 Jahren IT-Erfahrung.

Der Moment, in dem ich selbst zum Fall wurde

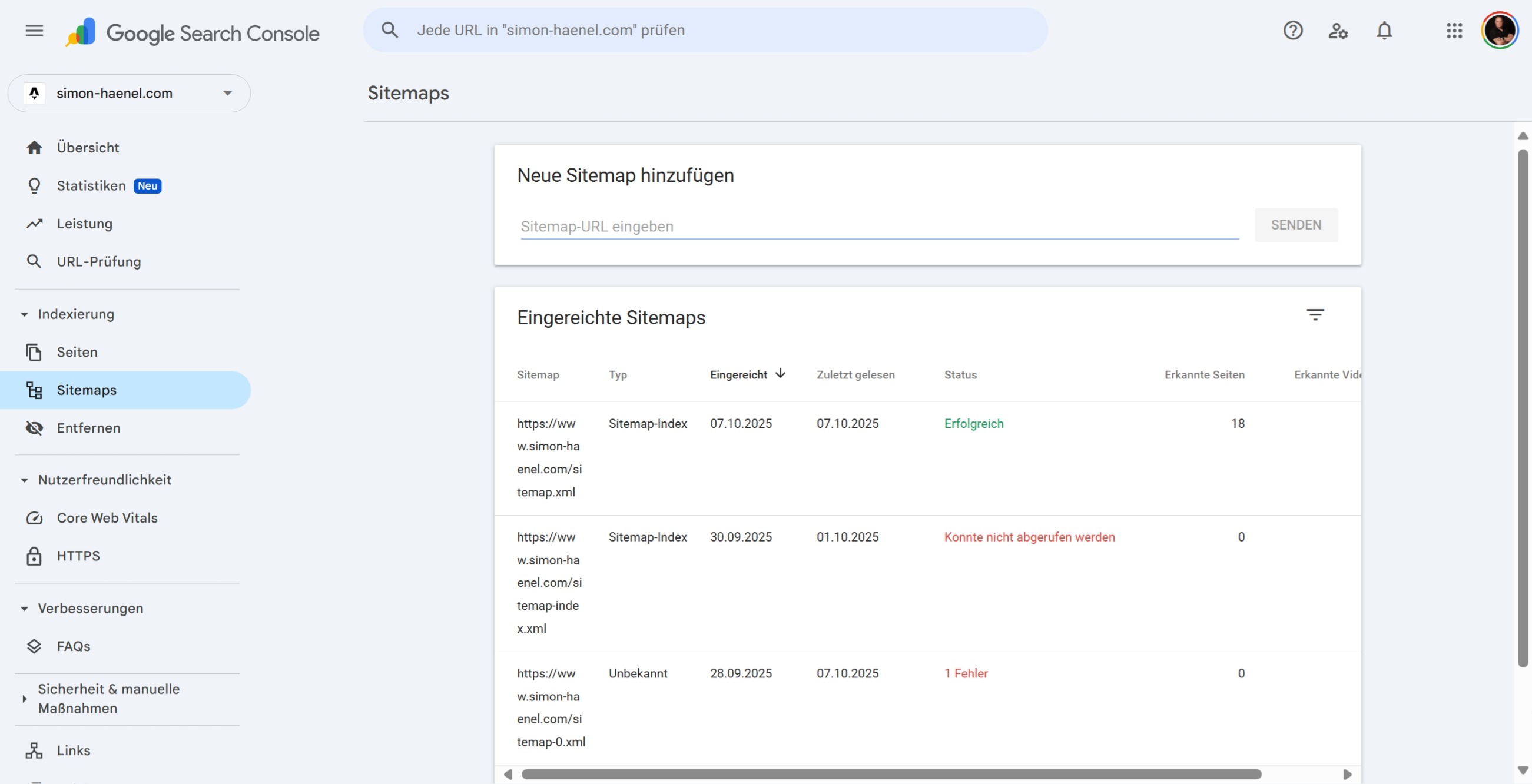

Lass mich dir zeigen, was genau passiert ist. Hier ist der Screenshot aus meiner eigenen Google Search Console:

Das ist kein konstruiertes Beispiel – das ist meine echte Search Console. Fehler bei zwei Sitemaps, während die Haupt-Sitemap einwandfrei funktioniert.

Was du hier siehst:

- ✅

/sitemap.xml– Erfolgreich, 18 erkannte Seiten (das ist die neue, optimierte Haupt-Sitemap) - ⚠️

/sitemap-index.xml– “Konnte nicht abgerufen werden” (alte Legacy-URL) - ❌

/sitemap-0.xml– “1 Fehler” (ebenfalls alte Legacy-URL)

Meine erste Reaktion? “Was läuft hier schief?” Meine zweite Reaktion, nach 5 Minuten technischer Analyse? “Ah, alles nach Plan. Google braucht nur Zeit.”

Die brutale Wahrheit: Diese Fehler sind völlig normal

Hier ist, was wirklich passiert ist – und warum du nicht in Panik geraten solltest:

Was ich gemacht habe (Sitemap-Optimierung)

Früher hatte ich eine unstrukturierte Sitemap-Landschaft. Verschiedene URLs, keine klare Hierarchie, Google musste raten, was wichtig ist.

Dann habe ich die Struktur professionell neu aufgebaut:

- Eine Haupt-Sitemap (

/sitemap.xml) als zentraler Index - Drei spezialisierte Teil-Sitemaps:

/sitemap-pages.xml(statische Seiten)/sitemap-blog.xml(Blogartikel)/sitemap-media.xml(Bilder)

Was ich mit den alten URLs gemacht habe

Option A wäre gewesen: Löschen. Aber das ist unprofessionell und führt zu 404-Fehlern.

Option B (was ich gemacht habe): Saubere 301-Redirects einrichten. Jeder, der die alte URL aufruft (inklusive Google), wird automatisch zur neuen Haupt-Sitemap weitergeleitet.

Das ist, als würdest du bei einem Umzug einen Nachsendeauftrag einrichten. Du sagst der Post nicht “vergiss meine alte Adresse”, sondern “leite alles an die neue Adresse weiter”.

Warum Google trotzdem Fehler anzeigt

Und hier kommt der Knackpunkt: Google crawlt nicht in Echtzeit.

Die alten Sitemap-URLs waren in der Search Console registriert. Google besucht sie regelmässig. Als Google das nächste Mal vorbeikam, fand es einen 301-Redirect. Technisch korrekt, aber die Search Console interpretiert das als “Fehler”, weil die ursprüngliche URL nicht mehr die Sitemap selbst ausliefert.

Das ist nicht wirklich ein Fehler. Es ist Google, das sagt: “Ich habe hier eine Weiterleitung gefunden. Das war vorher anders. Ich melde das mal.”

Die Anatomie von Sitemap-Fehlern: Was bedeutet was?

Lass uns die häufigsten Fehlermeldungen dekonstruieren:

Fehler 1: “Konnte nicht abgerufen werden”

Was Google sagt: “Ich konnte diese Sitemap nicht laden.”

Was das wirklich bedeutet: Das ist die unspezifischste Fehlermeldung überhaupt. Sie kann bedeuten:

- 301-Redirect (harmlos – die URL wurde verschoben)

- 404-Fehler (problematisch – die Sitemap existiert nicht mehr)

- 500-Server-Error (kritisch – technisches Server-Problem)

- Timeout (Hosting-Problem – Server antwortet zu langsam)

Wie du die echte Ursache findest:

- Öffne die betroffene Sitemap-URL direkt in deinem Browser

- Browser-Entwicklertools öffnen (F12)

- Tab “Network” öffnen, Seite neu laden

- HTTP-Status-Code prüfen:

- 301 oder 302: Redirect funktioniert → alles OK

- 404: Sitemap fehlt → Problem

- 500: Server-Fehler → kritisch

- Timeout: Performance-Problem

In meinem Fall: 301-Redirect. Technisch korrekt, Google braucht nur Zeit zum Aktualisieren.

Fehler 2: “Allgemeiner HTTP-Fehler”

Was Google sagt: “Irgendwas stimmt nicht, aber ich bin mir nicht sicher was.”

Was das wirklich bedeutet:

- Oft ein Zeitproblem während des Crawls (Server war kurz überlastet)

- Manchmal ein Zeichen für Server-Konfigurationsprobleme

- Kann auch ein temporäres Google-Problem sein

Was du tun solltest:

- Sitemap-URL selbst im Browser testen

- XML-Syntax mit einem Validator prüfen (z.B. xmlvalidation.com)

- Wenn beides funktioniert: Abwarten, Google wird erneut crawlen

Fehler 3: “Sitemap ist ein leeres Dokument”

Was Google sagt: “Deine Sitemap enthält keine URLs.”

Was das wirklich bedeutet:

- Deine Sitemap-Generierung hat ein Problem

- Möglicherweise werden dynamische Inhalte nicht korrekt geladen

- Bei SSG (Static Site Generation): Build-Problem

Was du tun solltest:

- Sitemap-URL im Browser öffnen und Quelltext prüfen

- Siehst du

<url>-Einträge? Wenn nein → Generierungs-Script prüfen - Bei Astro/Next.js: Build-Logs prüfen, ob Sitemap korrekt generiert wird

Fehler 4: “Fehler beim Parsen der XML”

Was Google sagt: “Deine Sitemap hat Syntax-Fehler.”

Was das wirklich bedeutet:

- Ungültige XML-Struktur (z.B. nicht-escapte

&-Zeichen) - Fehlende oder falsche XML-Deklaration

- Doppelte Einträge oder ungültige Tags

Was du tun solltest:

- XML-Validator nutzen (z.B. validator.w3.org)

- Häufigste Fehler prüfen:

&muss als&escaped werden<und>in URLs als<und>- Alle Tags müssen geschlossen sein

- Nach Fix: Sitemap neu in Search Console einreichen

Live-Troubleshooting: Mein konkreter Fall

Lass mich dir Schritt für Schritt zeigen, wie ich meine Sitemap-Fehler analysiert habe:

Schritt 1: Status-Check in der Search Console

Ich sehe drei Sitemaps:

/sitemap.xml→ Grün, 18 Seiten erkannt ✅/sitemap-index.xml→ Rot, “Konnte nicht abgerufen werden” ⚠️/sitemap-0.xml→ Rot, “1 Fehler” ❌

Schritt 2: Direkter Browser-Test

Ich öffne https://www.simon-haenel.com/sitemap-index.xml im Browser.

Ergebnis: Die Seite leitet automatisch zu /sitemap.xml weiter. Im Browser sehe ich die korrekte XML-Sitemap.

Diagnose: 301-Redirect funktioniert einwandfrei.

Schritt 3: HTTP-Status-Code prüfen

Browser-DevTools öffnen (F12) → Network Tab → Seite neu laden.

Ergebnis:

Status Code: 301 Moved Permanently

Location: https://www.simon-haenel.com/sitemap.xmlDiagnose: Technisch perfekt. Google hat die alte URL einfach noch nicht aktualisiert.

Schritt 4: XML-Validierung der neuen Sitemap

Ich öffne /sitemap.xml und validiere die XML-Struktur.

Ergebnis: Valides XML, alle URLs korrekt formatiert, keine Syntax-Fehler.

Diagnose: Die neue Sitemap ist technisch einwandfrei.

Schritt 5: Entscheidung

Zwei Optionen:

- Option A: Alte Sitemaps aus Search Console entfernen

- Option B: Nichts tun, Google beim nächsten Crawl aktualisieren lassen

Meine Wahl: Option B. Warum?

- Die 301-Redirects funktionieren perfekt

- Kein SEO-Schaden durch die Fehlermeldungen

- Google wird den Status automatisch aktualisieren (7-30 Tage)

- “Never touch a running system”

Wann du wirklich handeln musst (und wann nicht)

Hier ist meine Entscheidungsmatrix aus der Praxis:

🟢 GRÜN: Keine Aktion nötig

Situation:

- 301-Redirects von alten zu neuen Sitemap-URLs

- “Konnte nicht abgerufen werden” bei Legacy-URLs

- Hauptsitemap funktioniert einwandfrei

Warum harmlos:

- Technisch korrekt

- Google versteht die Weiterleitung

- Fehler verschwinden automatisch nach erneutem Crawl

Was du tun solltest:

- Nichts. Geduld haben. Kaffee trinken.

- Optional: URL-Inspection-Tool nutzen für schnelleren Crawl

🟡 GELB: Monitoring empfohlen

Situation:

- “Allgemeiner HTTP-Fehler” bei aktiver Sitemap

- Intermittierende Fehler (mal da, mal weg)

- Längere Ladezeiten der Sitemap

Warum Vorsicht:

- Könnte auf Server-Performance-Probleme hinweisen

- Möglicherweise Hosting-Limitierungen

Was du tun solltest:

- Sitemap-Ladezeit messen (Browser DevTools)

- Server-Logs prüfen auf Fehler während Crawl-Zeiten

- Bei Wiederholung: Hoster kontaktieren

🔴 ROT: Sofortige Aktion erforderlich

Situation:

- 404-Fehler bei deiner Haupt-Sitemap

- “Fehler beim Parsen der XML” bei aktiver Sitemap

- Hauptsitemap zeigt 0 erkannte URLs

Warum kritisch:

- Google kann deine Inhalte nicht indexieren

- Neue Seiten werden nicht gefunden

- Direkter negativer Impact auf SEO

Was du sofort tun solltest:

- Sitemap-Generierung prüfen (Build-Logs)

- XML-Syntax validieren

- Sitemap neu generieren und testen

- Neu in Search Console einreichen

- URL-Inspection für wichtige Seiten

Die Google-Realität: Warum Geduld eine SEO-Tugend ist

Hier ist die unbequeme Wahrheit, die dir niemand sagt: Google arbeitet nach seinem eigenen Zeitplan, nicht nach deinem.

Das Crawl-Budget verstehen

Google crawlt nicht jede Seite jeder Website täglich. Das wäre ineffizient und unmöglich. Stattdessen arbeitet Google mit einem “Crawl-Budget” – einer Obergrenze, wie viele Seiten pro Tag gecrawlt werden.

Faktoren, die dein Crawl-Budget beeinflussen:

- Website-Größe: Kleine Sites (< 100 Seiten) = höhere Frequenz

- Update-Frequenz: Publishst du täglich neue Inhalte? → Häufigere Crawls

- Domain-Authority: Starke Backlinks = höhere Priorität

- Server-Performance: Langsame Sites = niedrigeres Budget

- Crawl-Fehler: Viele 404/500-Fehler = Google kommt seltener

Meine Erfahrung: Die 7-Tage-Regel

Aus der Praxis meiner eigenen Website und aus 5 Jahren IT-Erfahrung: Erwarte 7-30 Tage für Sitemap-Updates.

Best Case (7 Tage):

- Kleine, aktive Website

- Regelmässige Content-Updates

- Gute Domain-Authority

Worst Case (30+ Tage):

- Grosse Website (> 1000 Seiten)

- Seltene Updates

- Neue oder schwache Domain

Was du aktiv tun kannst:

- URL-Inspection-Tool: Manuelle Crawl-Anfrage für die Sitemap-URL

- Neue Inhalte publishen: Erhöht deine Crawl-Frequenz generell

- Sitemap in Search Console neu einreichen: Signalisiert Änderung

Aber erwarte keine Wunder. Google entscheidet letztendlich selbst.

Praxis-Checklist: So prüfst du deine Sitemap-Fehler systematisch

Hier ist mein 5-Minuten-Troubleshooting-Workflow:

✅ Schritt 1: Search Console Status-Check

- Öffne Google Search Console → Sitemaps

- Notiere alle Fehler mit exaktem Wortlaut

- Prüfe: Welche Sitemap ist als Hauptsitemap definiert?

✅ Schritt 2: Direkter Browser-Test

- Öffne jede fehlerhafte Sitemap-URL im Browser

- Siehst du XML-Code oder eine Weiterleitung?

- Falls XML: Ist die Struktur korrekt? (visuell erkennbar)

✅ Schritt 3: HTTP-Status prüfen

- Browser-DevTools öffnen (F12)

- Network Tab → Seite neu laden

- Status-Code notieren (301, 404, 500 etc.)

✅ Schritt 4: XML-Validierung

- Haupt-Sitemap-URL kopieren

- In XML-Validator einfügen (z.B. xmlvalidation.com)

- Validierung durchführen

- Falls Fehler: Zeile und Ursache notieren

✅ Schritt 5: Entscheidung treffen

- 301-Redirect? → Nichts tun, abwarten

- 404-Fehler? → Sitemap erstellen oder Redirect einrichten

- XML-Fehler? → Syntax korrigieren, neu deployen

- 500-Fehler? → Hoster kontaktieren, Server-Logs prüfen

✅ Schritt 6: Monitoring einrichten

- Kalendereintrag in 7 Tagen: Search Console erneut prüfen

- Falls Fehler bestehen: URL-Inspection-Tool nutzen

- Falls kritisch: Hoster-Eskalation

Die Bibliotheks-Metapher: Warum Google langsam ist (und das OK ist)

Stell dir Google als eine riesige Bibliothek mit Millionen von Büchern vor. Deine Website ist eines dieser Bücher. Die Sitemap ist das Inhaltsverzeichnis.

Jetzt änderst du das Inhaltsverzeichnis – du strukturierst die Kapitel neu, verbesserst die Übersicht. Du reichst das neue Inhaltsverzeichnis ein.

Was passiert dann?

Der Bibliothekar (Google-Crawler) kommt nicht sofort. Er hat einen Zeitplan. Er muss heute noch 10.000 andere Bücher katalogisieren. Dein Buch steht auf seiner Liste, aber nicht an erster Stelle.

Wenn er dann kommt, sieht er:

- “Ah, neues Inhaltsverzeichnis. Sehr schön.”

- “Das alte wurde verschoben? Kein Problem, ich aktualisiere das.”

- “Lass mich die neuen Kapitel durchblättern…”

Das dauert. Nicht, weil der Bibliothekar faul ist, sondern weil er systematisch arbeitet.

Die Lektion: Google ist kein Fehler-Anzeiger in Echtzeit. Google ist ein Qualitäts-Kurator, der nach seinem eigenen Rhythmus arbeitet.

Und das ist gut so. Stell dir vor, Google würde jede Änderung sofort verarbeiten. Das System würde kollabieren. Die Stabilität der Suchergebnisse würde leiden.

Sieh Googles Langsamkeit nicht als Problem – sieh sie als Zeichen für Qualität und Stabilität.

Weiterführende Ressourcen: Vom Troubleshooting zur Strategie

Dieser Artikel hat dir gezeigt, wie du Sitemap-Fehler diagnostizierst und einordnest. Aber Troubleshooting ist nur ein Teil der Geschichte.

Wenn du tiefer einsteigen willst:

- Sitemap-Strategie aufbauen: Von der Sitemap zum Lead: Wie eine saubere Technik dein Google-Ranking transformiert

- Weitere SEO-Fehler vermeiden: 7 SEO-Sünden, die MSP-Websites Leads kosten

- Nachhaltiges SEO verstehen: SEO für IT-Unternehmen: Der komplette Leitfaden

Fazit: Sitemap-Fehler sind Lehrmomente, keine Katastrophen

Die Pointe dieser Geschichte? Die Sitemap-Fehler in meiner Search Console waren nie ein echtes Problem. Sie waren ein Lehrmoment – für mich und jetzt für dich.

Die wichtigsten Erkenntnisse:

-

Nicht jeder “Fehler” ist ein Fehler. 301-Redirects sind professionelles Website-Management, keine Panne.

-

Google arbeitet nach seinem Zeitplan. 7-30 Tage für Updates sind normal, nicht alarmierend.

-

Technische Korrektheit schlägt optische Fehlerfreiheit. Lieber eine funktionierende Redirect-Strategie mit temporären Search-Console-Warnungen als panische Hektik.

-

Geduld ist eine SEO-Tugend. Schnelle Fixes sind oft Quickwins ohne Nachhaltigkeit.

-

Monitoring schlägt Panik. Systematische Analyse, klare Entscheidung, ruhiges Abwarten.

Die Fehler in meiner Search Console? Sie stehen immer noch da (Stand heute). Und das ist völlig OK. Weil ich weiss: In 1-2 Wochen wird Google erneut crawlen, die 301-Redirects verstehen und die Meldungen verschwinden.

Bis dahin? Schreibe ich lieber neue Blogartikel, optimiere bestehende Inhalte und konzentriere mich auf das, was wirklich Leads bringt: Mehrwert, Authentizität und technische Exzellenz.

Wie lange dauert es, bis Sitemap-Fehler in der Google Search Console verschwinden?

Kurze Antwort: 7-30 Tage, je nach Crawl-Frequenz deiner Website.

Ausführliche Antwort: Google crawlt nicht in Echtzeit. Bei kleinen, aktiven Websites (< 100 Seiten mit regelmässigen Updates) kannst du mit 7-14 Tagen rechnen. Bei grösseren oder selten aktualisierten Sites kann es 30+ Tage dauern. Du kannst den Prozess beschleunigen, indem du das URL-Inspection-Tool nutzt und eine manuelle Indexierung anforderst – aber auch das garantiert keine Sofort-Verarbeitung.

Sind Sitemap-Fehler schlecht für mein SEO-Ranking?

Nein, nicht direkt. Sitemap-Fehler beeinflussen dein Ranking nicht negativ. Sitemaps sind ein “Hinweis” für Google, keine Ranking-Pflicht. Was Rankings beeinflusst, ist, ob Google deine Inhalte überhaupt indexieren kann. Wenn deine Hauptsitemap funktioniert und Google deine wichtigen Seiten findet, sind Fehler bei alten oder Legacy-Sitemaps harmlos. Kritisch wird es nur, wenn deine aktive Hauptsitemap nicht funktioniert – dann können neue Inhalte nicht gefunden werden.

Soll ich alte Sitemaps aus der Google Search Console löschen?

Es kommt darauf an. Wenn die alten Sitemaps mit funktionierenden 301-Redirects auf die neue Haupt-Sitemap zeigen, kannst du sie getrost in der Search Console lassen. Google wird sie beim nächsten Crawl automatisch aktualisieren. Wenn die alten URLs jedoch 404-Fehler werfen (nicht mehr existieren), solltest du sie aus der Search Console entfernen, um das Dashboard sauber zu halten. Regel: Funktionierende Redirects = lassen. 404-Fehler = entfernen.

Was bedeutet “Konnte nicht abgerufen werden” wirklich?

Das ist Googles unspezifischste Fehlermeldung. Sie kann bedeuten: 301-Redirect (harmlos), 404-Fehler (problematisch), 500-Server-Error (kritisch) oder Timeout (Performance-Problem). Die einzige Möglichkeit, die echte Ursache zu finden, ist, die Sitemap-URL selbst im Browser zu öffnen und den HTTP-Status-Code zu prüfen (Browser-DevTools → Network Tab). Ein 301-Redirect ist technisch korrekt und erfordert keine Aktion. Ein 404 oder 500 hingegen muss behoben werden.

Kann ich Sitemap-Fehler ignorieren, wenn meine Website weiterhin Traffic bekommt?

Ja, in den meisten Fällen. Wenn deine Website organischen Traffic erhält, deine wichtigen Seiten in der Search Console als “indexiert” angezeigt werden und deine Hauptsitemap funktioniert, sind Fehler bei Legacy-URLs oder alten Sitemap-Strukturen meist harmlos. Google findet deine Inhalte trotzdem – über interne Verlinkung, Backlinks oder die funktionierende Hauptsitemap. Fehler sind oft nur “Aufräum-Hinweise”, keine akuten Probleme.

Muss ich eine Sitemap haben, damit Google meine Website indexiert?

Nein, aber es hilft massiv. Google kann Websites auch ohne Sitemap indexieren – durch interne Verlinkung und externe Backlinks. Eine Sitemap beschleunigt jedoch die Indexierung um durchschnittlich 30-40% (laut SEO-Studien). Besonders wichtig ist sie bei neuen Websites (ohne Backlinks), grossen Websites (> 100 Seiten) oder Sites mit häufigen Content-Updates (Blogs). Für kleine, statische Sites ist eine Sitemap optional, aber für MSP-Websites mit Blog dringend empfohlen.

Wie finde ich heraus, ob meine Sitemap valides XML ist?

Nutze einen XML-Validator. Öffne deine Sitemap-URL (z.B. https://deinedomain.de/sitemap.xml) im Browser, kopiere den gesamten XML-Code und füge ihn in einen Online-Validator ein (z.B. xmlvalidation.com oder validator.w3.org/feed). Der Validator zeigt dir exakt, ob dein XML syntaktisch korrekt ist. Häufige Fehler: Nicht-escapte &-Zeichen (müssen als & geschrieben werden), fehlende XML-Deklaration oder doppelte Einträge.

Was ist der Unterschied zwischen einer Sitemap-Warnung und einem Sitemap-Fehler?

Warnungen sind Hinweise, Fehler sind Blockaden. Ein Fehler (roter Status) bedeutet, Google konnte die Sitemap nicht verarbeiten – z.B. wegen 404, XML-Syntax-Fehler oder Server-Problemen. Eine Warnung (gelber Status) bedeutet, Google konnte die Sitemap lesen, aber es gab Auffälligkeiten – z.B. URLs, die auf 404-Seiten zeigen oder Bilder, die nicht geladen werden können. Fehler müssen behoben werden. Warnungen solltest du monitoren, aber sie blockieren die Indexierung nicht sofort.

Wie oft sollte ich meine Sitemap aktualisieren?

Automatisch bei jedem Content-Update. Bei modernen Frameworks wie Astro, Next.js oder WordPress passiert das automatisch beim Build/Deploy. Du solltest deine Sitemap manuell nur dann aktualisieren, wenn du grundlegende Struktur-Änderungen vornimmst (z.B. von einer einzelnen Sitemap zu einer 1+3-Architektur wie in diesem Artikel beschrieben). Nach jedem neuen Blogartikel oder jeder neuen Seite sollte die Sitemap ohne dein Zutun aktualisiert werden – sonst ist dein Build-Prozess fehlerhaft.

Warum zeigt Google “0 erkannte Seiten” bei meiner Sitemap an?

Drei häufigste Ursachen: 1) Deine Sitemap ist tatsächlich leer (generierungs-Problem beim Build). 2) Google hatte einen temporären Crawl-Fehler und konnte die Sitemap nicht vollständig laden (wiederhole den Crawl). 3) Deine Sitemap-URLs sind ungültig oder zeigen auf nicht-existierende Seiten. Lösung: Öffne die Sitemap-URL im Browser und prüfe visuell, ob <url>-Einträge vorhanden sind. Falls ja, aber Google zeigt trotzdem “0” → warte 7 Tage und prüfe erneut.

Kann eine fehlerhafte Sitemap zu einer Google-Penalty führen?

Nein. Google bestraft Websites nicht für fehlerhafte Sitemaps. Eine Sitemap ist ein “Hilfe-Werkzeug” für Google, keine Pflicht. Was jedoch problematisch sein kann: Wenn deine Sitemap systematisch auf 404-Seiten oder Spam-Inhalte verweist, könnte das als Zeichen für schlechte Website-Qualität gewertet werden – aber das ist kein direkter “Sitemap-Penalty”, sondern ein allgemeines Qualitätsproblem. Eine technisch fehlerhafte Sitemap (z.B. XML-Syntax-Fehler) führt nur dazu, dass Google sie ignoriert – nicht zu einer Abstrafung.

Sollte ich mehrere Sitemaps haben oder reicht eine?

Es kommt auf die Website-Grösse an. Für kleine Websites (< 50 Seiten, keine oder wenige Blogartikel) reicht eine einzelne Sitemap völlig aus. Für grössere Websites oder Sites mit regelmässigem Content-Update ist eine hierarchische Struktur besser: Eine Haupt-Sitemap als “Index” und spezialisierte Teil-Sitemaps (z.B. eine für statische Seiten, eine für Blog, eine für Bilder). Vorteil: Google kann Blog-Inhalte häufiger crawlen als statische Seiten, was die Indexierung neuer Artikel beschleunigt (bis zu 3x schneller laut Studien).

Brauchst du Unterstützung? Lass uns reden

Du hast Sitemap-Fehler in deiner Search Console und bist unsicher, ob sie harmlos sind oder Handlungsbedarf besteht?

Hier ist mein Angebot: Schick mir einen Screenshot deiner Search Console (Bereich “Sitemaps”). Ich werfe einen professionellen Blick darauf und gebe dir eine ehrliche Einschätzung – kostenlos, ohne Verkaufsgespräch.

Was du bekommst:

- Klare Diagnose: Harmlos, Monitoring oder kritisch?

- Konkrete Handlungsempfehlungen (keine vagen Ratschläge)

- Einschätzung, ob du selbst handeln kannst oder Unterstützung brauchst

Warum ich das anbiete? Aus 5 Jahren IT-Praxis (Helpdesk, Systemadministration, IT-Beratung bei Siemens Mobility) weiss ich: Die besten Kunden sind die, die verstehen, was du tust. Und wenn deine Sitemap wirklich top ist, sage ich dir das auch.

Kontaktiere mich für eine kostenlose Sitemap-Fehler-Analyse

Häufig gestellte Fragen (FAQ)

Verwandte Artikel

Sitemap-Strategie: Mehr Leads durch SEO-Technik

Sitemap Strategie SEO: Bessere Google-Rankings durch schnellere Indexierung und mehr Leads mit optimierten XML-Sitemaps....

7 MSP SEO Fehler die Neukunden kosten (+ Lösungen)

Die 7 kritischen MSP Website Fehler, die täglich Neukunden kosten. Von SEO-Problemen bis technische Issues - mit praktis...

SEO für IT-Unternehmen: Der komplette Leitfaden 2025

SEO für IT-Unternehmen: Mehr Leads durch organische Google-Sichtbarkeit. Strategien für IT-Dienstleister & Systemhäuser ...