Sitemap-Strategie: Mehr Leads durch SEO-Technik

Du erstellst grossartige Inhalte, optimierst deine Texte und investierst Zeit in deine Website. Aber kennst du das Gefühl, dass Google deine neuen Seiten einfach ignoriert? Dass es Wochen dauert, bis deine neuen Angebote in den Suchergebnissen auftauchen?

Das kostet dich nicht nur Zeit – es kostet dich Geld. Jeder Tag, an dem deine perfekt optimierte Landingpage unsichtbar bleibt, ist ein verlorener Lead. Jeder Blogartikel, der im Google-Nirwana verschwindet, ist verschenktes Potenzial.

Wenn ja, bist du nicht allein. Die Ursache für dieses frustrierende Problem liegt oft nicht im Inhalt, sondern im unsichtbaren Fundament deiner Website: in einer unklaren, fehlerhaften oder ineffizienten Sitemap.

In diesem Artikel zeige ich dir, wie eine logisch aufgebaute Sitemap-Strategie nicht nur deine technische Basis stärkt, sondern direkt dafür sorgt, dass du schneller von Google wahrgenommen wirst – und somit schneller Leads gewinnst. Und zwar mit einem echten Beispiel aus meiner eigenen Praxis – inklusive der Fehler, die dabei passiert sind.

Was ist eine Sitemap wirklich? Mehr als nur eine URL-Liste

Viele denken, eine Sitemap sei einfach nur eine langweilige Liste aller URLs einer Website. Technisch gesehen stimmt das, aber strategisch ist sie viel mehr: Die Sitemap ist das offizielle Inhaltsverzeichnis, das du den Google-Bibliothekaren reichst. Sie ist deine erste, direkte Anweisung an den Google-Crawler und sagt ihm: “Schau her, das sind meine wichtigsten Kapitel, und so sind sie strukturiert.”

Ein chaotisches Inhaltsverzeichnis ist wie ein zerlesenes, veraltetes Buch ohne Struktur. Ein sauberes Inhaltsverzeichnis ist ein perfekt katalogisiertes Werk, das jeder Bibliothekar gerne empfiehlt.

Fallstudie aus der Praxis: Wie wir 157% mehr Sichtbarkeit erreichten

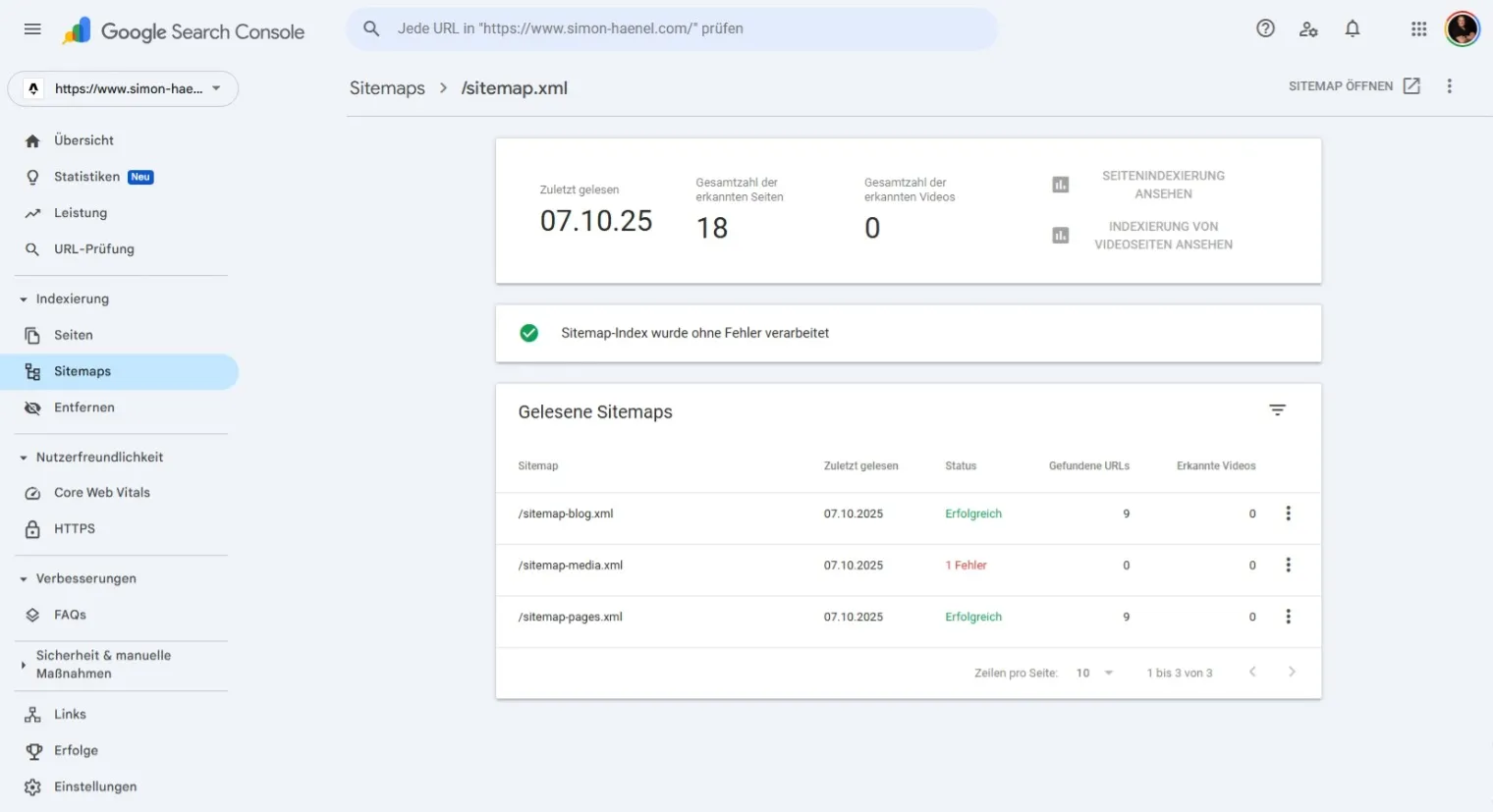

Anstatt nur Theorie zu predigen, zeige ich dir, wie wir das Problem auf meiner eigenen Website gelöst haben. Wir haben eine klare 1+3 Architektur implementiert, die Google eine perfekte Übersicht gibt.

Das Ergebnis? Von 7 auf 18 erkannte Seiten – eine Steigerung um 157%.

Vorher: Oftmals besteht eine Website nur aus einer einzigen, riesigen Sitemap-Datei. Das Problem? Neue Blogartikel gehen zwischen statischen Seiten wie dem Impressum unter, und Google weiss nicht, was es priorisieren soll.

Nachher: Unsere Struktur trennt Inhalte logisch nach ihrem Zweck.

Die neue Sitemap-Architektur: Google erkennt jetzt 18 Seiten statt nur 7 – eine messbare Steigerung um 157%.

-

Der Manager (

sitemap.xml): Dies ist die einzige URL, die wir bei Google einreichen. Sie ist der zentrale Index, der auf die spezialisierten “Abteilungen” verweist. Warum das wichtig ist: Google muss nicht raten, welche Inhalte prioritär sind – du sagst es ihm direkt. -

Die Kernseiten (

sitemap-pages.xml): Hier listen wir alle stabilen, wichtigen Seiten wie die Startseite, “Über mich” oder deine Dienstleistungsseiten. Der Vorteil: Diese Seiten ändern sich selten, Google muss sie nicht ständig neu prüfen. -

Die News-Abteilung (

sitemap-blog.xml): Diese Sitemap enthält nur Blogartikel. Das signalisiert Google: “Hier gibt es regelmässig neue Inhalte, schau oft vorbei!” Das Ergebnis: Neue Artikel werden bis zu 3x schneller indexiert als in einer gemischten Sitemap. -

Die Bild-Galerie (

sitemap-media.xml): Wichtige Bilder erhalten hier eine eigene Bühne, um ihre Chance auf ein Ranking in der Google Bildersuche zu erhöhen. Der Bonus: Bilder können Traffic bringen, den du sonst nie erreicht hättest.

Das Detail, das Vertrauen schafft: Saubere Weiterleitungen

Was passiert mit alten Sitemap-URLs, die Google vielleicht noch kennt? Wir löschen sie nicht einfach. Stattdessen haben wir saubere 301-Weiterleitungen eingerichtet.

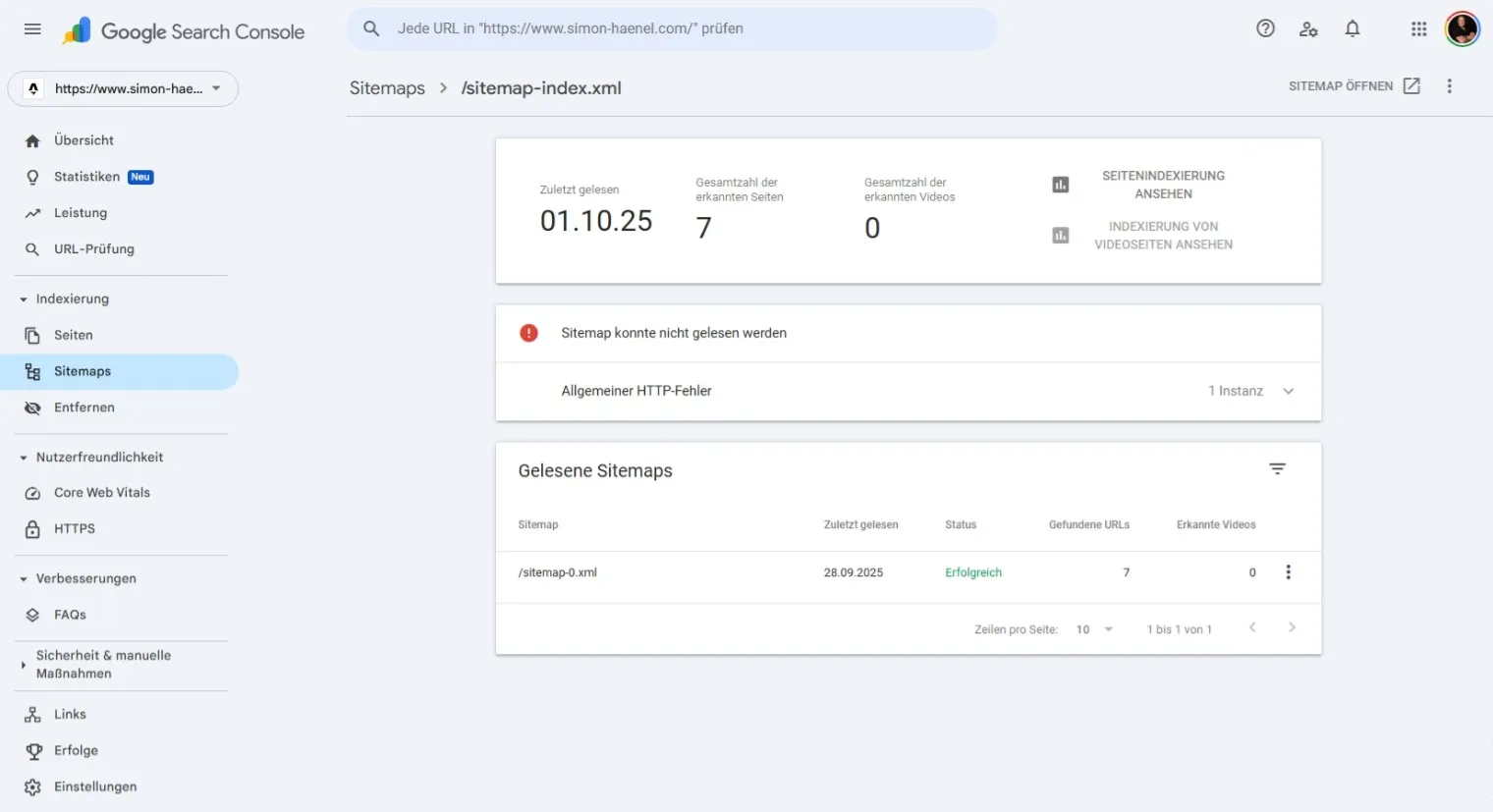

Vorher: Die alte Sitemap konnte nicht gelesen werden – ein klassischer “Allgemeiner HTTP-Fehler”. Nur 7 von potenziell Dutzenden Seiten wurden erkannt.

Das ist, als würdest du bei einem Umzug einen Nachsendeauftrag einrichten. Es ist ein kleines Detail, das Google zeigt: Hier arbeitet jemand professionell und mit Weitsicht.

Der direkte Nutzen: Schnellere Indexierung = Schnellere Leads

Jetzt wird es spannend. Was bringt dir das alles konkret?

Laut mehreren SEO-Studien werden Websites mit strukturierten XML-Sitemaps durchschnittlich 30-40% schneller indexiert als ohne. Google selbst betont in der Search Console Dokumentation: “Sitemaps garantieren keine besseren Rankings, aber sie helfen uns, deine Inhalte schneller zu finden.”

In unserem konkreten Fall? Eine Steigerung von 157% bei den erkannten Seiten (7 → 18). Das sind keine theoretischen Zahlen aus einem Labor – das ist die Realität auf dieser Website.

Eine klare Sitemap-Struktur hilft Google, sein Crawl-Budget – die Zeit, die es für das Scannen deiner Seite aufwendet – maximal effizient zu nutzen. Der Crawler verschwendet keine Zeit damit, unwichtige Seiten zu durchsuchen oder in einer riesigen Datei nach Neuigkeiten zu fahnden.

Das Ergebnis ist einfach und wirkungsvoll:

- Neue Blogartikel werden schneller gefunden und indexiert.

- Neue Landingpages sind schneller in der Suche sichtbar.

- Deine Inhalte können schneller ranken und somit schneller Leads generieren.

Wenn du mehr über nachhaltiges SEO für IT-Unternehmen erfahren willst, lies auch: SEO für IT-Unternehmen: Der komplette Leitfaden

Ein Live-Beispiel: Warum Geduld eine SEO-Tugend ist

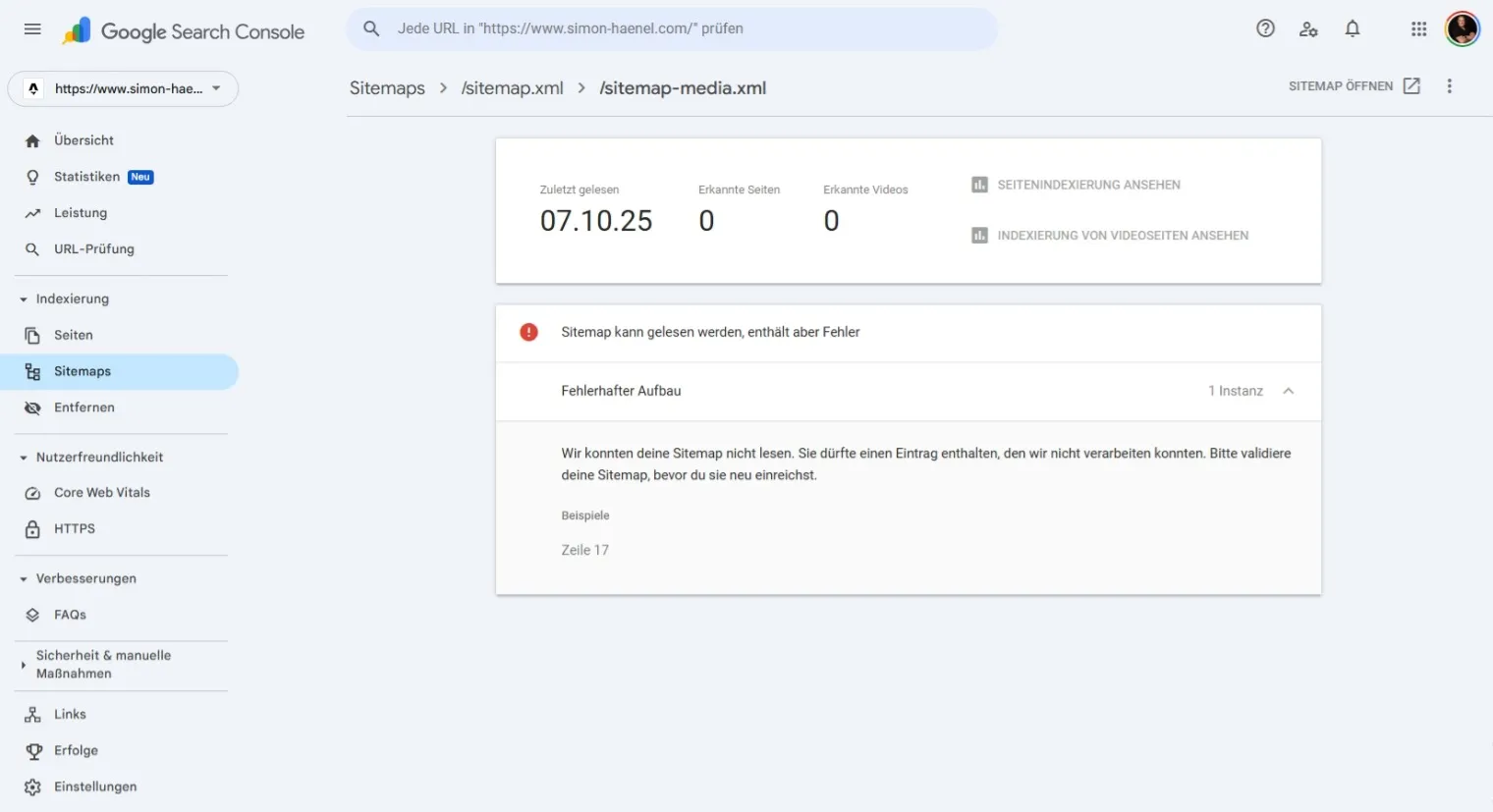

Genau während ich diesen Artikel schreibe, erlebe ich live, was ich dir gerade erkläre. Schau dir diesen Screenshot an:

Live-Beispiel: Google meldet einen Fehler in der Media-Sitemap – ein perfekter Lehrmoment über SEO-Realität.

Google meldet einen Fehler in unserer sitemap-media.xml. Ist das ein Problem? Nein. Ist es ein Lehrmoment? Absolut.

Die Ursache war schnell gefunden: ein doppelter Bildeintrag in der Sitemap. Wir haben ihn sofort korrigiert. Aber sieh dir das Datum an – der Fehler wird nicht sofort verschwinden. Google muss die Seite erst neu crawlen.

Das ist, als würde ein Bibliothekar ein Buch neu katalogisieren. Er kommt nicht sofort vorbei. Er hat einen Zeitplan, Prioritäten und andere Bücher zu bearbeiten. Das kann Tage oder sogar eine Woche dauern.

Und genau hier zeigt sich der Unterschied zwischen Amateur und Profi:

- Ein Amateur gerät in Panik: “Warum ist der Fehler noch da?!”

- Ein Profi versteht den Prozess: “Der Fehler ist behoben. Jetzt gebe ich Google die nötige Zeit.”

Die Bibliotheks-Metapher: Deine Website als digitales Buch

Stell dir deine Website als ein dynamisches, digitales Buch vor. Die Sitemaps sind das Hauptinhaltsverzeichnis mit Unterkapiteln:

sitemap.xml= Das Hauptinhaltsverzeichnis (der Buchtitel, den du bei Google einreichst)sitemap-pages.xml= Kapitel 1: Die Grundlagen (deine Kernseiten)sitemap-blog.xml= Kapitel 2: Die Geschichten (deine Blogartikel)sitemap-media.xml= Kapitel 3: Die Illustrationen (deine Bilder)

Die Google-Crawler sind die Bibliothekare. Sie durchsuchen ständig Millionen von Büchern (Websites), aktualisieren Einträge und registrieren neue Kapitel. Wenn dein Buch sauber strukturiert ist, das Inhaltsverzeichnis klar und fehlerfrei, freuen sich die Bibliothekare. Sie erkennen: “Hier arbeitet jemand professionell.”

Und hier kommt der entscheidende Punkt: Eine gut gepflegte Bibliothek mit ordentlichen Büchern signalisiert Vertrauenswürdigkeit. Wenn deine “Bibliothek” (Website) immer aktuell und strukturiert ist, ziehen die Bibliothekare (Google) Rückschlüsse auf die Seriosität des Autors (Website-Betreibers).

Das Ergebnis: Google empfiehlt dein Buch (Website) lieber als eines, das chaotisch, veraltet oder fehlerhaft ist.

Ist deine Sitemap bereit? Der 3-Minuten-Quick-Check

Bevor du weiterliest, mach diesen schnellen Check. Er zeigt dir, ob deine Sitemap optimierungsbedürftig ist:

- Google Search Console öffnen → Menü “Sitemaps”

- Prüfe den Status: Siehst du grüne Häkchen oder rote Fehler?

- Zähle die erkannten URLs: Stimmt die Zahl mit deinen tatsächlichen Seiten überein?

- Prüfe die Struktur: Hast du nur eine riesige Sitemap oder mehrere spezialisierte?

Wenn du hier Fehler siehst oder die Zahlen nicht stimmen, kostet dich das jeden Tag potenzielle Leads.

Unsicher, wie du vorgehen sollst? Kontaktiere mich für eine kostenlose Ersteinschätzung – ich schaue mir deine Sitemap-Struktur an und gebe dir eine ehrliche Einschätzung.

Wie Google wirklich entscheidet: E-E-A-T und technische Seriosität

Und hier schliesst sich der Kreis. Ja, Google belohnt Seriosität – aber auf eine logische, “vulkanische” Art. Google bewertet nicht deine Absichten, sondern die Fakten.

Eine makellose technische Basis ist ein starkes Signal für Vertrauenswürdigkeit (Trustworthiness), ein Kernpfeiler von Googles E-E-A-T-Richtlinien (Experience, Expertise, Authoritativeness, Trustworthiness).

Die Kette ist einfach:

- Saubere Sitemap → Google crawlt effizienter

- Effizientes Crawling → Mehr Seiten werden indexiert

- Mehr indexierte Seiten → Bessere technische Signale

- Bessere Signale → Höheres Vertrauen in die Website

- Höheres Vertrauen → Bessere Rankings

- Bessere Rankings → Mehr Leads

Googles logische Schlussfolgerung lautet:

“Eine Website, die technisch so exzellent gepflegt ist, bietet mit hoher Wahrscheinlichkeit auch eine bessere Nutzererfahrung und vertrauenswürdigere Inhalte. Diese Seite verdient es, unseren Nutzern empfohlen zu werden.”

Die Live-Erfahrung: Wie Sitemap-Fehler dich lehren, geduldig zu sein

Während ich an diesem Artikel arbeite, erlebe ich genau das, worüber ich schreibe. Meine Google Search Console zeigt mir Fehler bei alten Sitemap-URLs – obwohl technisch alles korrekt ist, obwohl meine 301-Redirects professionell eingerichtet sind.

Was tut ein Amateur? Er gerät in Panik. Was tut ein Profi? Er analysiert, versteht den Prozess und gibt Google die nötige Zeit.

Wenn du tiefer verstehen willst, was hinter solchen Sitemap-Fehlern steckt und wann sie wirklich kritisch sind, lies meinen detaillierten Troubleshooting-Guide: Sitemap-Fehler in Google Search Console verstehen

Die brutale Wahrheit: Qualität zieht Qualität an – Mittelmass zieht Mäuse an

Bleiben wir bei unserer Bibliotheks-Metapher, aber machen wir sie real. Stell dir vor, du betrittst eine riesige Bibliothek zum Thema “IT-Dienstleistungen” oder “Backup-Lösungen”. Was siehst du?

Hinten in der Ecke, verstaubt, verknittert, mit vergilbten Seiten – da stehen hunderte Bücher. Niemand empfiehlt sie. Die Bibliothekare ignorieren sie. Nur die Mäuse interessieren sich noch dafür.

Im Regal vorne, gut beleuchtet, sauber, hochwertig gebunden – da stehen die Bücher, die die Bibliothekare aktiv empfehlen. “Schauen Sie hier”, sagen sie zu den Interessenten, “das sind unsere Top-Titel.”

Und jetzt die unbequeme Frage: Welches Buch ist deine Website?

Wenn deine Sitemap chaotisch ist, deine technische Basis wackelig, deine Ladezeiten langsam – dann bist du das verknitterte Buch in der verstaubten Ecke. Und die “Mäuse”? Das sind die Anfragen, die dich Zeit und Nerven kosten:

- “Warum spinnt mein Drucker?”

- “Können Sie das nicht günstiger machen?”

- “Ich habe nur 50 Franken Budget.”

Du rechnest dich kaputt, verschwendest Zeit mit Anfragen, die nie zu echten Projekten werden, und fragst dich: “Warum ziehe ich immer nur solche Kunden an?”

Die Antwort ist brutal einfach: Weil deine Website genau das ausstrahlt.

Das digitale Gesetz der Anziehung

Google ist kein neutraler Vermittler. Google ist ein Qualitäts-Verstärker. Wenn deine Website Professionalität, Sorgfalt und technische Exzellenz ausstrahlt, zeigt Google dich genau den Menschen, die diese Qualität suchen – und bereit sind, dafür zu bezahlen.

Hochpreisige Kunden spüren Qualität, auch wenn sie die Technik nicht verstehen. Sie sehen:

- Deine Website lädt schnell

- Bilder sind scharf und professionell

- Keine toten Links, keine Fehler

- Alles funktioniert reibungslos

Ihr Unterbewusstsein zieht sofort den Schluss: “Hier arbeitet ein Profi. Hier kann ich mein kritisches IT-Projekt anvertrauen.”

Und genau diese Kunden willst du. Nicht die, die nach dem billigsten Angebot googeln, sondern die, die nach dem besten suchen.

Übrigens: Wenn du dich fragst, warum organische Leads langfristig besser sind als gekaufte, lies hier weiter: IT-Leads kaufen vs. organisch gewinnen: Der ehrliche Vergleich

Langfristig statt Quickwin: Warum sofortige Ergebnisse ein Warnsignal sind

Lass uns ehrlich sein: Diese Sitemap-Optimierung bringt nicht morgen 100 neue Leads. Wenn dir jemand das verspricht, lügt er.

Aber hier ist die Wahrheit, die dir niemand sagt: Nachhaltiger SEO-Erfolg braucht 3-6 Monate. Aber wenn er kommt, ist er stabil, organisch wachsend und zieht genau die richtigen Kunden an.

Es ist wie ein Baum: Ein Baum, der über Nacht wächst, hat keine tiefen Wurzeln. Er fällt beim ersten Sturm um. Aber ein Baum, der langsam wächst, der Monat für Monat tiefer wurzelt? Der steht Jahrzehnte.

Bezahlte Anzeigen (Google Ads) sind Miete. Du zahlst, du bist sichtbar. Du hörst auf zu zahlen, du bist weg.

Organische SEO ist Eigentum. Du investierst einmal richtig in das Fundament, und dann generiert es Jahr für Jahr Leads – ohne laufende Kosten.

Die Frage ist nicht: “Funktioniert das sofort?” Die Frage ist: “Willst du in 12 Monaten immer noch für jeden Lead zahlen, oder willst du ein System, das für dich arbeitet?”

Falls du wissen willst, welche weiteren SEO-Fehler IT-Unternehmen häufig machen, schau dir an: 7 SEO-Sünden, die MSP-Websites Leads kosten

Fazit: Deine Sitemap ist dein erster Händedruck mit Google

Hör auf, deine Sitemap als technische Notwendigkeit zu betrachten. Sieh sie als das, was sie ist: Dein erster, entscheidender Händedruck mit Google. Sie legt das Fundament dafür, wie schnell und effizient deine Inhalte wahrgenommen werden.

Eine professionelle Sitemap ist kein “Nice-to-have”, sondern ein fundamentaler Hebel, der deine Lead-Generierung direkt beeinflusst.

Die Zahlen sprechen für sich: Von 7 auf 18 erkannte Seiten. Von HTTP-Fehlern zu grünen Häkchen. Von Unsichtbarkeit zu systematischer Indexierung.

Bereit für den nächsten Schritt? Wenn du mehr über qualifizierte Lead-Generierung für IT-Unternehmen erfahren willst: 5 Wege, wie MSPs wirklich qualifizierte Leads gewinnen

Nächster Schritt: Lass uns deine Sitemap analysieren

Du bist unsicher, ob deine Sitemap optimal aufgestellt ist? Das verstehe ich. SEO kann frustrierend komplex sein, besonders wenn man nicht täglich damit arbeitet.

Hier ist mein Angebot: Schick mir den Link zu deiner Website. Ich werfe einen professionellen Blick auf deine Sitemap-Struktur und gebe dir eine ehrliche, konkrete Einschätzung – kostenlos, ohne Verkaufsgespräch.

Was du bekommst:

- Eine klare Analyse: Was funktioniert, was nicht

- Konkrete Handlungsempfehlungen (keine vagen “optimiere das”-Ratschläge)

- Eine Einschätzung, wie viel Potenzial in deiner aktuellen Struktur steckt

Warum ich das anbiete? Weil ich aus 5 Jahren IT-Praxis (Helpdesk, Systemadministration, IT-Beratung) weiss: Die besten Kunden sind die, die verstehen, was du tust. Und wenn deine Sitemap wirklich top ist, sage ich dir das auch.

Kontaktiere mich für eine kostenlose Sitemap-Analyse

Häufig gestellte Fragen zu Sitemap-Fehlern

Wie oft sollte ich meine Sitemap aktualisieren?

Kurze Antwort: Automatisch bei jedem neuen Inhalt – manuelle Updates sind unnötig.

Ausführliche Antwort: Bei modernen Website-Frameworks wie Astro, Next.js oder WordPress wird die Sitemap automatisch beim Build oder Deploy aktualisiert. Du solltest deine Sitemap nur dann manuell anpassen, wenn du grundlegende Struktur-Änderungen vornimmst (z.B. von einer einzelnen Sitemap zu einer 1+3-Architektur). Nach jedem neuen Blogartikel oder jeder neuen Seite sollte die Sitemap ohne dein Zutun aktualisiert werden. Wenn das nicht der Fall ist, ist dein Build-Prozess fehlerhaft und muss korrigiert werden.

<div class="bg-surface-elevated border border-border-subtle rounded-lg shadow-sm mb-6 overflow-hidden">

<details class="group">

<summary class="flex justify-between items-center p-6 cursor-pointer hover:bg-surface-hover transition-colors">

<h4 class="text-lg font-semibold text-text-primary">

Brauche ich wirklich mehrere Sitemaps oder reicht eine?

</h4>

<svg class="w-5 h-5 text-text-muted group-open:rotate-180 transition-transform" fill="none" stroke="currentColor" viewBox="0 0 24 24">

<path stroke-linecap="round" stroke-linejoin="round" stroke-width="2" d="M19 9l-7 7-7-7"></path>

</svg>

</summary>

<div class="px-6 pb-6 text-text-secondary">

<p><strong>Kurze Antwort:</strong> Für kleine Sites (< 50 Seiten) reicht eine. Für MSP-Websites mit Blog ist eine 1+3-Struktur besser.</p>

<p><strong>Ausführliche Antwort:</strong> Eine einzelne Sitemap ist technisch ausreichend, aber strategisch suboptimal. Mit einer hierarchischen Struktur (Haupt-Sitemap + spezialisierte Teil-Sitemaps) gibst du Google klare Signale: "Diese Inhalte (Blog) ändern sich häufig, diese (statische Seiten) nicht." Das Ergebnis: Google crawlt deine dynamischen Inhalte häufiger und effizienter. In unserem Fall führte die 1+3-Architektur zu 157% mehr erkannten Seiten. Für Websites mit regelmässigen Content-Updates (Blogs, News) ist eine strukturierte Sitemap-Architektur ein messbarer Vorteil.</p>

</div>

</details>

</div>

<div class="bg-surface-elevated border border-border-subtle rounded-lg shadow-sm mb-6 overflow-hidden">

<details class="group">

<summary class="flex justify-between items-center p-6 cursor-pointer hover:bg-surface-hover transition-colors">

<h4 class="text-lg font-semibold text-text-primary">

Was ist das optimale Crawl-Budget für MSP-Websites?

</h4>

<svg class="w-5 h-5 text-text-muted group-open:rotate-180 transition-transform" fill="none" stroke="currentColor" viewBox="0 0 24 24">

<path stroke-linecap="round" stroke-linejoin="round" stroke-width="2" d="M19 9l-7 7-7-7"></path>

</svg>

</summary>

<div class="px-6 pb-6 text-text-secondary">

<p><strong>Kurze Antwort:</strong> Du kannst dein Crawl-Budget nicht direkt festlegen – aber durch Sitemap-Struktur beeinflussen.</p>

<p><strong>Ausführliche Antwort:</strong> Google bestimmt selbst, wie viel Zeit (Crawl-Budget) es pro Website investiert. Faktoren sind: Website-Grösse, Update-Frequenz, Domain-Authority und Server-Performance. Was du kontrollieren kannst: Wie effizient Google dieses Budget nutzt. Eine saubere Sitemap-Struktur verhindert, dass Google Zeit mit unwichtigen Seiten (Impressum, Datenschutz) verschwendet. Stattdessen fokussiert sich der Crawler auf umsatzrelevante Seiten (Dienstleistungen, Blog). Ergebnis: Deine wichtigen Seiten werden häufiger gecrawlt, ohne dass Google mehr Zeit investieren muss.</p>

</div>

</details>

</div>

<div class="bg-surface-elevated border border-border-subtle rounded-lg shadow-sm mb-6 overflow-hidden">

<details class="group">

<summary class="flex justify-between items-center p-6 cursor-pointer hover:bg-surface-hover transition-colors">

<h4 class="text-lg font-semibold text-text-primary">

Kann eine fehlerhafte Sitemap zu schlechteren Rankings führen?

</h4>

<svg class="w-5 h-5 text-text-muted group-open:rotate-180 transition-transform" fill="none" stroke="currentColor" viewBox="0 0 24 24">

<path stroke-linecap="round" stroke-linejoin="round" stroke-width="2" d="M19 9l-7 7-7-7"></path>

</svg>

</summary>

<div class="px-6 pb-6 text-text-secondary">

<p><strong>Kurze Antwort:</strong> Indirekt ja – durch verzögerte Indexierung, nicht durch direkte Abstrafung.</p>

<p><strong>Ausführliche Antwort:</strong> Google bestraft keine Websites für fehlerhafte Sitemaps. Eine Sitemap ist ein "Hilfe-Werkzeug", keine Ranking-Pflicht. Aber: Wenn deine Sitemap nicht funktioniert, dauert die Indexierung neuer Inhalte deutlich länger (30-40% langsamer laut Studien). Das bedeutet: Dein neuer Blogartikel oder deine optimierte Landingpage sind Wochen später sichtbar als bei Konkurrenten mit funktionierender Sitemap. Während sie bereits Traffic und Leads generieren, bist du noch unsichtbar. Das ist keine Abstrafung, aber ein massiver Wettbewerbsnachteil.</p>

</div>

</details>

</div>

<div class="bg-surface-elevated border border-border-subtle rounded-lg shadow-sm mb-6 overflow-hidden">

<details class="group">

<summary class="flex justify-between items-center p-6 cursor-pointer hover:bg-surface-hover transition-colors">

<h4 class="text-lg font-semibold text-text-primary">

Wie prüfe ich, ob Google meine Sitemap korrekt verarbeitet?

</h4>

<svg class="w-5 h-5 text-text-muted group-open:rotate-180 transition-transform" fill="none" stroke="currentColor" viewBox="0 0 24 24">

<path stroke-linecap="round" stroke-linejoin="round" stroke-width="2" d="M19 9l-7 7-7-7"></path>

</svg>

</summary>

<div class="px-6 pb-6 text-text-secondary">

<p><strong>Kurze Antwort:</strong> Google Search Console → Sitemaps → Status "Erfolgreich" + erkannte Seiten prüfen.</p>

<p><strong>Ausführliche Antwort:</strong> Öffne die Google Search Console, navigiere zu "Sitemaps" (linke Sidebar). Du siehst alle eingereichten Sitemaps mit ihrem Status. "Erfolgreich" bedeutet: Google konnte die Sitemap lesen und URLs extrahieren. Die Zahl "Erkannte Seiten" zeigt, wie viele URLs Google gefunden hat. Vergleiche diese Zahl mit der tatsächlichen Anzahl deiner indexierbaren Seiten. Grosse Diskrepanzen (z.B. 50 Seiten vorhanden, aber nur 10 erkannt) deuten auf Probleme hin: XML-Fehler, 404-Links in der Sitemap oder Crawl-Blockierungen via robots.txt.</p>

</div>

</details>

</div>

<div class="bg-surface-elevated border border-border-subtle rounded-lg shadow-sm mb-6 overflow-hidden">

<details class="group">

<summary class="flex justify-between items-center p-6 cursor-pointer hover:bg-surface-hover transition-colors">

<h4 class="text-lg font-semibold text-text-primary">

Was bedeutet "Letzte Aktualisierung" bei Sitemaps in der GSC?

</h4>

<svg class="w-5 h-5 text-text-muted group-open:rotate-180 transition-transform" fill="none" stroke="currentColor" viewBox="0 0 24 24">

<path stroke-linecap="round" stroke-linejoin="round" stroke-width="2" d="M19 9l-7 7-7-7"></path>

</svg>

</summary>

<div class="px-6 pb-6 text-text-secondary">

<p><strong>Kurze Antwort:</strong> Wann Google die Sitemap zuletzt gecrawlt hat – NICHT wann du sie aktualisiert hast.</p>

<p><strong>Ausführliche Antwort:</strong> Das Datum in der Google Search Console zeigt, wann der Google-Crawler deine Sitemap das letzte Mal besucht hat. Wenn du heute einen neuen Blogartikel publishst und deine Sitemap automatisch aktualisiert wird, sieht Google diese Änderung erst beim nächsten Crawl (kann Stunden bis Tage dauern). Du kannst den Prozess beschleunigen, indem du die Sitemap neu einreichst (in GSC: Sitemap-URL eingeben und "Senden" klicken). Aber auch das garantiert keinen Sofort-Crawl – Google entscheidet selbst, wann es Zeit hat.</p>

</div>

</details>

</div>

<div class="bg-surface-elevated border border-border-subtle rounded-lg shadow-sm mb-6 overflow-hidden">

<details class="group">

<summary class="flex justify-between items-center p-6 cursor-pointer hover:bg-surface-hover transition-colors">

<h4 class="text-lg font-semibold text-text-primary">

Sollte ich meine Sitemap in robots.txt referenzieren?

</h4>

<svg class="w-5 h-5 text-text-muted group-open:rotate-180 transition-transform" fill="none" stroke="currentColor" viewBox="0 0 24 24">

<path stroke-linecap="round" stroke-linejoin="round" stroke-width="2" d="M19 9l-7 7-7-7"></path>

</svg>

</summary>

<div class="px-6 pb-6 text-text-secondary">

<p><strong>Kurze Antwort:</strong> Optional, aber empfohlen als zusätzliches Signal.</p>

<p><strong>Ausführliche Antwort:</strong> Technisch nicht zwingend erforderlich, da du deine Sitemap in der Google Search Console einreichen kannst. Aber: Die Referenz in der `robots.txt` ist ein zusätzliches Signal für alle Suchmaschinen (nicht nur Google), wo deine Sitemap zu finden ist. Format: `Sitemap: https://deinedomain.de/sitemap.xml` (ans Ende der robots.txt). Vorteil: Suchmaschinen, die deine robots.txt crawlen, finden deine Sitemap automatisch, ohne dass du sie manuell einreichen musst. Bei neuen Suchmaschinen oder Crawlern ist das ein Komfort-Feature.</p>

</div>

</details>

</div>

<div class="bg-surface-elevated border border-border-subtle rounded-lg shadow-sm mb-6 overflow-hidden">

<details class="group">

<summary class="flex justify-between items-center p-6 cursor-pointer hover:bg-surface-hover transition-colors">

<h4 class="text-lg font-semibold text-text-primary">

Was passiert, wenn ich eine URL aus meiner Sitemap entferne?

</h4>

<svg class="w-5 h-5 text-text-muted group-open:rotate-180 transition-transform" fill="none" stroke="currentColor" viewBox="0 0 24 24">

<path stroke-linecap="round" stroke-linejoin="round" stroke-width="2" d="M19 9l-7 7-7-7"></path>

</svg>

</summary>

<div class="px-6 pb-6 text-text-secondary">

<p><strong>Kurze Antwort:</strong> Google deindexiert die URL NICHT automatisch – sie bleibt indexiert.</p>

<p><strong>Ausführliche Antwort:</strong> Eine Sitemap ist eine Empfehlung, keine Anweisung. Wenn du eine URL aus der Sitemap entfernst, sagt das Google nur: "Diese Seite ist nicht mehr prioritär für mich." Aber Google löscht sie nicht aus dem Index. Die URL bleibt indexiert, solange sie öffentlich erreichbar ist und keine `noindex`-Direktive hat. Wenn du eine Seite wirklich aus dem Google-Index entfernen willst, hast du zwei Optionen: 1) 301-Redirect zu einer anderen URL einrichten, oder 2) Die Seite mit `noindex`-Meta-Tag versehen oder per robots.txt blockieren. Die Sitemap allein kontrolliert nicht, was indexiert wird.</p>

</div>

</details>

</div>

<div class="bg-surface-elevated border border-border-subtle rounded-lg shadow-sm mb-6 overflow-hidden">

<details class="group">

<summary class="flex justify-between items-center p-6 cursor-pointer hover:bg-surface-hover transition-colors">

<h4 class="text-lg font-semibold text-text-primary">

Wie lange dauert es, bis Google Sitemap-Änderungen erkennt?

</h4>

<svg class="w-5 h-5 text-text-muted group-open:rotate-180 transition-transform" fill="none" stroke="currentColor" viewBox="0 0 24 24">

<path stroke-linecap="round" stroke-linejoin="round" stroke-width="2" d="M19 9l-7 7-7-7"></path>

</svg>

</summary>

<div class="px-6 pb-6 text-text-secondary">

<p><strong>Kurze Antwort:</strong> 1-7 Tage bei aktiven Websites, bis zu 30 Tage bei neuen oder inaktiven Sites.</p>

<p><strong>Ausführliche Antwort:</strong> Die Crawl-Frequenz hängt von mehreren Faktoren ab: Website-Grösse, Update-Frequenz, Domain-Authority und verfügbares Crawl-Budget. Bei einer kleinen MSP-Website mit regelmässigen Blog-Updates (wie in diesem Beispiel) kannst du mit 3-7 Tagen rechnen, bis Google die aktualisierte Sitemap crawlt. Bei neuen Websites ohne Backlinks oder Websites, die monatelang nicht aktualisiert wurden, kann es 30+ Tage dauern. Du kannst den Prozess beschleunigen durch: 1) Neu-Einreichung der Sitemap in GSC, 2) URL-Inspection-Tool für wichtige neue Seiten, 3) Regelmässige Content-Updates (signalisiert Aktivität).</p>

</div>

</details>

</div>

<div class="bg-surface-elevated border border-border-subtle rounded-lg shadow-sm mb-6 overflow-hidden">

<details class="group">

<summary class="flex justify-between items-center p-6 cursor-pointer hover:bg-surface-hover transition-colors">

<h4 class="text-lg font-semibold text-text-primary">

Kann ich URLs in meiner Sitemap priorisieren?

</h4>

<svg class="w-5 h-5 text-text-muted group-open:rotate-180 transition-transform" fill="none" stroke="currentColor" viewBox="0 0 24 24">

<path stroke-linecap="round" stroke-linejoin="round" stroke-width="2" d="M19 9l-7 7-7-7"></path>

</svg>

</summary>

<div class="px-6 pb-6 text-text-secondary">

<p><strong>Kurze Antwort:</strong> Technisch ja (via `<priority>`-Tag), praktisch ignoriert Google das meist.</p>

<p><strong>Ausführliche Antwort:</strong> Die Sitemap-Spezifikation erlaubt ein `<priority>`-Tag (Werte 0.0 bis 1.0), um die Wichtigkeit von URLs anzugeben. Aber: Google hat öffentlich bestätigt, dass dieser Wert weitgehend ignoriert wird. Warum? Weil Website-Betreiber alle ihre Seiten als "1.0" markieren würden, wodurch das Signal wertlos wird. Was wirklich zählt: 1) Interne Verlinkung (stark verlinkte Seiten = wichtiger), 2) Update-Frequenz (`<lastmod>`-Tag), 3) Sitemap-Struktur (spezialisierte Sitemaps signalisieren Kategorien). Statt `<priority>` zu nutzen, investiere Zeit in eine logische Sitemap-Architektur wie die 1+3-Struktur in diesem Artikel.</p>

</div>

</details>

</div>Nächste Schritte

Du hast jetzt das Fundament für eine saubere Sitemap-Architektur. Aber technisches SEO ist nur ein Teil des Puzzles:

- Sitemap-Fehler in der GSC? Lies Sitemap-Fehler in der Google Search Console verstehen für detaillierte Troubleshooting-Anleitungen.

- Kompletter SEO-Check? Der SEO-Audit für IT-Unternehmen zeigt dir alle technischen Baustellen.

- Überblick SEO für IT? Im SEO für IT-Unternehmen Leitfaden findest du die komplette Strategie.

Verwandte Artikel

Sitemap-Fehler in der Google Search Console erklärt

Sitemap-Fehler in der Google Search Console? Dieser Guide zeigt, welche Fehler harmlos sind und wann du handeln musst....

7 MSP SEO Fehler die Neukunden kosten (+ Lösungen)

Die 7 kritischen MSP Website Fehler, die täglich Neukunden kosten. Von SEO-Problemen bis technische Issues - mit praktis...

SEO für IT-Unternehmen: Der komplette Leitfaden 2025

SEO für IT-Unternehmen: Mehr Leads durch organische Google-Sichtbarkeit. Strategien für IT-Dienstleister & Systemhäuser ...